Auf dem Weg zu quantifizierbar sicheren autonomen dynamischen Systemen

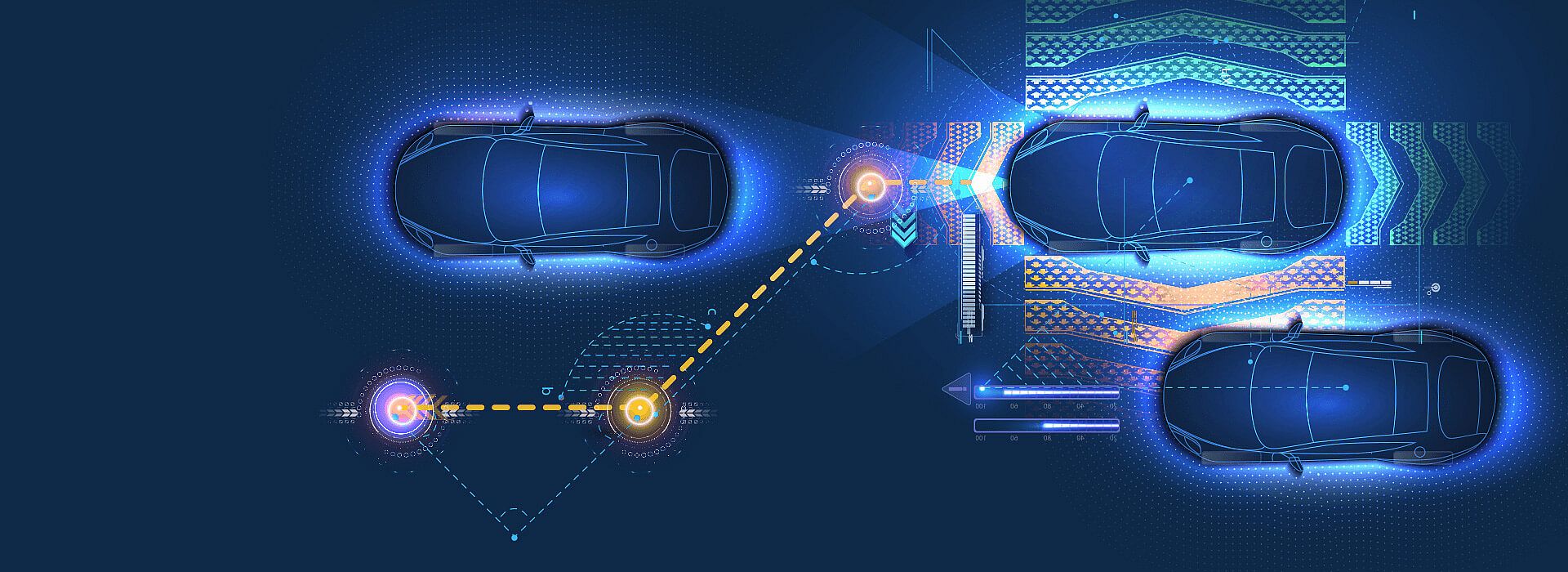

Autonome Systeme müssen Aufgaben in hochdynamischen Umgebungen lösen, z. B. beim autonomen Fahren oder bei Drohnenlieferdiensten. Dabei sind sie mit Umgebungsunsicherheiten konfrontiert, die durch ungenaue Wahrnehmung, inakkurate Vorhersagen und fehlerhafte dynamische Modelle der Umgebung entstehen. Bei der Implementierung solcher Systeme auf Basis lernfähiger und klassischer KI-Technologie kommen weitere Formen der Unsicherheit hinzu. Diese Kombination von Fehlerquellen macht es schwierig, eine quantifizierbare Sicherheitsargumentation für solche Systeme abzuleiten. Im Projekt MUKI wird untersucht, wie Laufzeitverifikation mit Verifkation während der Entwicklungsphase unter einem gemeinsamen Rahmenwerk kombiniert werden können, um ein quantifizierbares Sicherheitsargument unter der beschriebenen Aggregation von Unsicherheiten zu erhalten.

Eine zentrale Forschungsfrage an der Schnittstelle zwischen klassischem Safety-Engineering und der Entwicklung von autonomen Systemen lautet wie folgt: Wie muss eine Architektur für autonome Systeme entwickelt werden, um eine quantifizierbare Sicherheitsargumentation unter Berücksichtigung von Unsicherheiten der Umwelt und der KI zu ermöglichen?

fortiss legt hier den Fokus auf die Verfeinerung und Detaillierung erster Standards, die die klassische Sicherheitsargumentation erweitern, um sie auf KI-basierte autonome Systeme anzuwenden.

Die Forschung von fortiss trägt in den folgenden Bereichen bei:

01.02.2021 – 31.12.2021